- PARTICULES (ACCÉLÉRATEURS DE)

- PARTICULES (ACCÉLÉRATEURS DE)Les modèles et théories qui synthétisent notre compréhension actuelle de la matière et de ses constituants élémentaires – molécules, atomes, particules – ont été confrontés à une multitude d’observations expérimentales. Pour réaliser ces expériences, c’est-à-dire observer l’infiniment petit, on utilise des sondes appropriées capables de pénétrer la matière et d’interagir avec sa structure ultime.Quoi de plus logique que de bombarder la matière avec les objets les plus petits qui soient: des particules?Les premières expériences suivirent la découverte de la radioactivité naturelle, qui permit de disposer de sources de particules de faible vitesse: particules 見 ou noyaux d’hélium (rayonnement 見) et électrons (rayonnement 廓). La physique nucléaire expérimentale démarra avec l’étude des effets de ces rayonnements sur les noyaux atomiques. Très vite, on éprouva le besoin de changer les paramètres des expériences, donc de disposer de faisceaux plus intenses, mieux focalisés, et surtout réglables en énergie. L’unité élémentaire de mesure pour cette dernière est l’électronvolt (1 eV = 1,602 憐 10-19 J), ainsi que ses multiples (keV, MeV, GeV, TeV, etc.). L’idée de construire des accélérateurs, c’est-à-dire de créer un faisceau de particules puis de l’accélérer, était née. Ces machines se sont donc développées pour les besoins de la recherche fondamentale en physique nucléaire.L’histoire des accélérateurs commence en 1930, avec les premiers appareils électrostatiques. Une série d’inventions techniques permet de repousser les limitations inhérentes à l’utilisation de hautes tensions et d’atteindre le mégaélectronvolt. En parallèle, le cyclotron fait son apparition. La multitraversée de l’espace accélérateur fait gagner un facteur dix en énergie (fig. 1).Dans un premier temps, la Seconde Guerre mondiale freine l’effort entrepris. En revanche, elle donne une justification supplémentaire à la physique nucléaire dont les progrès sont essentiels pour la maîtrise de l’énergie nucléaire à des fins pacifiques ou militaires. De plus, la guerre a entraîné des investissements technologiques très importants, en particulier dans le domaine des sources radiofréquences de puissance (radars) qui vont être à l’origine du développement des accélérateurs linéaires à 200 et 3 000 mégahertz. Vers 1950, la course à la haute énergie reprend avec les premières machines circulaires du type synchrotron, pour accélérer des électrons, puis des protons, au-delà du gigaélectronvolt. C’est le début de l’ère des grands accélérateurs, avec la création de plusieurs laboratoires aux États-Unis (Berkeley, Brookhaven...). En 1954, les pays européens décident de mettre leurs moyens en commun, et créent le Conseil européen pour la recherche nucléaire (C.E.R.N.), à Genève – qui est devenu le Cern, le Laboratoire européen pour la physique des particules. À ces énergies, des détails de plus en plus fins de la matière peuvent être observés. On peut maintenant s’intéresser aux constituants du noyau, et les grands accélérateurs deviennent aussi les outils de base pour les physiciens des particules élémentaires. Les résultats expérimentaux sont largement à la mesure des moyens mis en œuvre. Les années 1960 sont infiniment riches en constructions d’accélérateurs et en découvertes expérimentales. La liste des nouvelles particules élémentaires ne cesse de s’allonger et des théories s’élaborent pour rendre compte de la nouvelle vision du monde subnucléaire. Les énormes forces entre particules mises en jeu demandent des énergies de plus en plus élevées pour tester la validité des modèles théoriques.Pendant la décennie de 1970, le mouvement vers la haute énergie continue, à la demande des physiciens des particules élémentaires. Les futures expériences ne se feront plus en envoyant le faisceau après accélération sur une cible fixe; pour gagner en énergie disponible, dans le centre de masse de la réaction, des collisionneurs seront désormais employés. Ce sont des machines dans lesquelles circulent en sens inverse un faisceau de particules et un faisceau d’antiparticules. Les deux faisceaux sont mis en collision au niveau du détecteur de physique intégré à l’accélérateur. Les quarks et autres particules élémentaires sont découverts. Néanmoins, le gigantisme de la nouvelle génération de machines nécessaires, combiné aux problèmes économiques, amène les scientifiques à se remettre en cause. Des choix sont indispensables, et il devient important de se concerter au niveau international dans un souci de complémentarité et, également, de se demander si la fin justifie les moyens. Cette réflexion et cette remise en cause sont d’autant plus nécessaires que la physique nucléaire reste à l’écart de ce mouvement vers la très haute énergie et réclame, elle aussi, des accélérateurs d’énergie intermédiaire.On diversifie les projectiles, en utilisant abondamment les faisceaux de particules secondaires (mésons, kaons, antiprotons), ou en accélérant des particules polarisées. La physique du noyau, qui était restée un peu dans l’ombre des particules élémentaires, revient en force. De nombreux laboratoires se constituent autour d’accélérateurs à ions lourds pour une physique plus macroscopique de la matière nucléaire, à des énergies voisines ou légèrement supérieures à la barrière coulombienne.Parallèlement à l’utilisation intensive des accélérateurs pour les besoins de la physique nucléaire et des particules élémentaires, des applications pour de nouveaux domaines de recherche commencent à émerger.Les collisionneurs à électrons-positrons de la première génération, peu à peu délaissés par les physiciens des particules élémentaires, parce que de trop faible énergie, sont tout d’abord utilisés de façon parasitaire et ensuite totalement accaparés par les utilisateurs de lumière synchrotron. Cette lumière, dont le spectre couvre une large gamme de longueur d’ondes, du visible aux rayons 塚, est émise par les particules à la traversée des champs magnétiques de guidage. Elle a des propriétés remarquables pour l’étude de la matière condensée, inerte ou vivante, et intéresse une grande variété de domaines de la science.Des applications plus pratiques pour les accélérateurs se développent. En médecine, les premières expériences de traitement du cancer par des ions lourds ont lieu aux États-Unis, tandis que des industriels mettent sur le marché des cyclotrons pour traitement à partir de particules secondaires (neutrons ou pions). Des cyclotrons de même type servent à la production de radio-isotopes, en pharmacologie et en biologie (étude de divers métabolismes), ou encore pour des analyses fines industrielles ou scientifiques (érosion, dépôts, pollution, datation, archéologie...). On imagine l’utilisation d’accélérateurs pour la stérilisation (produits alimentaires, appareils chirurgicaux...). Depuis 1980, les tendances se confirment.La physique des particules élémentaires a déjà bénéficié de quatre supercollisionneurs: trois machines électrons-positrons, le L.E.P. (Large Electron Positron Collider) au Cern, le S.L.C. (Stanford Linear Collider) à Stanford (États-Unis) et Tristan à Tsukuba (Japon), et une machine électrons-protons, Hera à Hambourg. On prépare déjà l’an 2000 avec des projets encore plus gigantesques de collisionneurs protons-antiprotons à 10 ou 20 TeV par faisceau. Malgré les progrès technologiques considérables réalisés dans l’utilisation d’aimants ou de cavités accélératrices supraconducteurs, la taille des machines ne cesse de croître et dépassera les 100 km avant la fin du millénaire. Pour aller encore plus loin, il faut imaginer des principes nouveaux, permettant de gagner au moins un ordre de grandeur sur l’efficacité des accélérateurs. La physique nucléaire se concentre sur les énergies intermédiaires et diversifie ses outils: plusieurs cyclotrons à ions lourds, utilisant des électroaimants supraconducteurs pour les plus récents, des machines à électrons à flux continu et très intense. Les projets pour la prochaine décennie concernent des usines à particules secondaires, kaons, neutrinos, antiprotons...On assiste à un développement exceptionnel de l’utilisation du rayonnement synchrotron. De nombreuses machines, délivrant des faisceaux intenses et brillants de photons dans les domaines de l’ultraviolet du vide et des rayons X mous, ont été construites. L’utilisation d’aimants spéciaux, wigglers et onduleurs, permet d’obtenir des sources de rayonnement réglables de qualité exceptionnelle. Les machines de la prochaine génération se proposent de gagner plusieurs ordres de grandeur sur la qualité des faisceaux de photons. Parmi elles, citons la machine européenne E.S.R.F. (European Synchroton Radiation Facility), à Grenoble, ainsi que des projets comparables aux États-Unis et au Japon.L’utilisation des accélérateurs pour des applications pratiques, en particulier en médecine et en pharmacologie, s’intensifie. Des projets sur l’incinération, par bombardement avec un faisceau de protons, des déchets radioactifs à longue durée de vie sont à l’étude. On pense également à de nouvelles filières pour la production d’énergie, comme la fusion inertielle par ions lourds. Les grands groupes industriels s’installent en force autour des sources de lumière synchrotron. Plusieurs machines pour la production de circuits intégrés submicrométriques (microlithographie par rayons X) sont en construction.Pendant une soixantaine d’années, du premier Cockcroft-Walton de 1930, petit appareil de laboratoire, au L.E.P. de 1988, gigantesque machine de 27 km de circonférence, les accélérateurs se sont développés pour satisfaire principalement les besoins de la physique nucléaire et de la physique des particules élémentaires. Ils ont intimement contribué à notre vision moderne du monde nucléaire et subnucléaire, et représentent un parc immense d’outils conçus à partir de théories et de techniques très élaborées. Leur application à d’autres disciplines et à l’industrie se poursuit. Les prochaines années ouvrent l’ère de la diversification.1. Principes générauxUn accélérateur de particules est un instrument qui permet de communiquer de l’énergie à un faisceau de particules. A priori, on ne saurait agir sur une particule neutre. En revanche, pourvu qu’elle porte une charge, une particule est sensible à l’action d’un champ électrique E ou d’un champ magnétique B. Fabriquer un accélérateur consiste à interposer sur la trajectoire d’un faisceau un champ électromagnétique.L’équation vectorielle qui régit la dynamique d’une particule chargée dans un champ électromagnétique est de la forme:

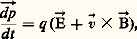

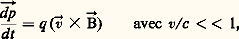

où ら = m 轢v est le vecteur quantité de mouvement, m la masse de la particule,v le vecteur vitesse et q la charge.つ et ち ont des actions très différentes sur le mouvement. À la traversée d’un champ électrique つ, le module du vecteur ら est modifié: il y a accélération parallèlement à つ. En revanche, à la traversée d’un champ magnétique d’induction ち, du fait du produit vectoriel par le vecteur vitessev, le module de ら ne change pas. Le champ magnétique ne fait que modifier l’orientation du vecteur ら. La manière de distribuer les champs électromagnétiques dépend fondamentalement de la particule considérée, qui peut aller de la plus légère des particules – l’électron 漣, à la plus lourde – l’ion uranium. Elle dépend aussi beaucoup de la gamme d’énergie à couvrir avec l’accélérateur. L’énergie finale est le plus souvent obtenue en mettant bout à bout plusieurs types d’accélérateurs.Le premier étage est bien évidemment la source de particules. Pour les électrons, des surfaces thermomissives sont employées, pour les protons et les ions, des plasmas denses. Une fois les particules créées, il faut les extraire de la source. Cette extraction se fait par l’intermédiaire de champs électriques qui communiquent aux particules leur première accélération et, en général, les focalisent. Le faisceau doit circuler dans une chambre à vide. En effet, il est fondamental d’éviter que les particules soient déviées ou perdues par diffusion ou interaction avec les molécules d’un gaz. Le vide requis dépend des probabilités de détérioration du faisceau sur la longueur de trajectoire et varie de 10-4 à 10-10 pascal, soit environ de 10-6 à 10-12 mmHg.Action du champ électriqueSi, entre deux électrodes, on crée une différence de potentiel V, une particule de charge + q créée au niveau de l’électrode positive V sera accélérée par le champ électrique. Elle se déplacera à vitesse croissante vers l’électrode de masse (fig. 2).Le bilan de la traversée de cette différence de potentiel est un gain d’énergie W = q V, qui se mesure en électronvolts (eV). Lorsqu’il s’agit d’une particule lourde dont le noyau est composé de A nucléons, on se réfère le plus souvent à l’énergie par nucléon:

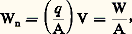

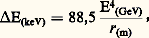

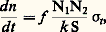

où ら = m 轢v est le vecteur quantité de mouvement, m la masse de la particule,v le vecteur vitesse et q la charge.つ et ち ont des actions très différentes sur le mouvement. À la traversée d’un champ électrique つ, le module du vecteur ら est modifié: il y a accélération parallèlement à つ. En revanche, à la traversée d’un champ magnétique d’induction ち, du fait du produit vectoriel par le vecteur vitessev, le module de ら ne change pas. Le champ magnétique ne fait que modifier l’orientation du vecteur ら. La manière de distribuer les champs électromagnétiques dépend fondamentalement de la particule considérée, qui peut aller de la plus légère des particules – l’électron 漣, à la plus lourde – l’ion uranium. Elle dépend aussi beaucoup de la gamme d’énergie à couvrir avec l’accélérateur. L’énergie finale est le plus souvent obtenue en mettant bout à bout plusieurs types d’accélérateurs.Le premier étage est bien évidemment la source de particules. Pour les électrons, des surfaces thermomissives sont employées, pour les protons et les ions, des plasmas denses. Une fois les particules créées, il faut les extraire de la source. Cette extraction se fait par l’intermédiaire de champs électriques qui communiquent aux particules leur première accélération et, en général, les focalisent. Le faisceau doit circuler dans une chambre à vide. En effet, il est fondamental d’éviter que les particules soient déviées ou perdues par diffusion ou interaction avec les molécules d’un gaz. Le vide requis dépend des probabilités de détérioration du faisceau sur la longueur de trajectoire et varie de 10-4 à 10-10 pascal, soit environ de 10-6 à 10-12 mmHg.Action du champ électriqueSi, entre deux électrodes, on crée une différence de potentiel V, une particule de charge + q créée au niveau de l’électrode positive V sera accélérée par le champ électrique. Elle se déplacera à vitesse croissante vers l’électrode de masse (fig. 2).Le bilan de la traversée de cette différence de potentiel est un gain d’énergie W = q V, qui se mesure en électronvolts (eV). Lorsqu’il s’agit d’une particule lourde dont le noyau est composé de A nucléons, on se réfère le plus souvent à l’énergie par nucléon: exprimée en eV/A, keV/A, etc.Induction magnétique et guidage des particulesSi, entre les deux pôles d’un aimant, règne un champ d’induction magnétique homogène B, une particule de charge q , de masse m et de vitesse v décrit une trajectoire circulaire de rayon r (fig. 3):

exprimée en eV/A, keV/A, etc.Induction magnétique et guidage des particulesSi, entre les deux pôles d’un aimant, règne un champ d’induction magnétique homogène B, une particule de charge q , de masse m et de vitesse v décrit une trajectoire circulaire de rayon r (fig. 3): Avec une succession de secteurs à champ homogène dipolaire, on courbe l’axe du faisceau et on guide les particules chargées tout au long d’une ligne de transport.Toutefois, à l’origine de la ligne de transport, les particules qui constituent le faisceau n’ont pas les mêmes conditions initiales. Le faisceau a des dimensions transverses en position et en angle. Pour l’empêcher de diverger, et maintenir tout au long de la ligne des dimensions transverses raisonnables autour de l’axe faisceau, on introduit des lentilles de focalisation. L’effet focalisant recherché peut être obtenu en insérant une lentille magnétique quadrupolaire (quadrupôle) sur l’axe du faisceau (fig. 4 a et b).Dans ce type d’élément, le champ magnétique est proportionnel à la distance par rapport à l’axe de la lentille. La distance focale f s’exprime en fonction du gradient d’induction transverse G de la lentille, de sa longueur L et de la rigidité p /q de la particule:

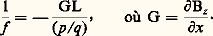

Avec une succession de secteurs à champ homogène dipolaire, on courbe l’axe du faisceau et on guide les particules chargées tout au long d’une ligne de transport.Toutefois, à l’origine de la ligne de transport, les particules qui constituent le faisceau n’ont pas les mêmes conditions initiales. Le faisceau a des dimensions transverses en position et en angle. Pour l’empêcher de diverger, et maintenir tout au long de la ligne des dimensions transverses raisonnables autour de l’axe faisceau, on introduit des lentilles de focalisation. L’effet focalisant recherché peut être obtenu en insérant une lentille magnétique quadrupolaire (quadrupôle) sur l’axe du faisceau (fig. 4 a et b).Dans ce type d’élément, le champ magnétique est proportionnel à la distance par rapport à l’axe de la lentille. La distance focale f s’exprime en fonction du gradient d’induction transverse G de la lentille, de sa longueur L et de la rigidité p /q de la particule: Il est à noter que les distances focales dans les plans x et z de symétrie de la lentille sont de signe opposé: en d’autres termes, si la lentille focalise dans le plan x , elle défocalise dans le plan z .On peut combiner les deux effets de courbure et de focalisation dans un électroaimant unique de type dipolaire mais dont les pièces polaires ne sont pas parallèles. Une méthode différente consisterait à faire passer le faisceau décentré à travers un quadrupôle.L’optique des faisceaux de particules chargées dans un champ magnétique est semblable à l’optique des faisceaux lumineux. Les prismes de l’optique classique sont remplacés par les dipôles magnétiques, les lentilles par les quadrupôles magnétiques. On retrouve l’équivalent de la dispersion chromatique à la sortie d’un prisme, l’équivalent des aberrations liées aux défauts de réalisation des éléments optiques, etc.Il est important de signaler que le champ électromagnétique effectif qui agit sur une particule a deux origines: le champ extérieur qu’on applique pour guider et accélérer le faisceau par l’intermédiaire d’électroaimants et de tensions, d’une part, et le champ propre du faisceau lui-même, d’autre part. Ce dernier, appelé champ de charge d’espace, a une composante électrique défocalisante (répulsion coulombienne de particules de même charge) et une composante magnétique focalisante (les charges en mouvement constituant un courant qui génère un champ magnétique). À basse vitesse, et principalement au niveau de la source, la force électrique du champ de charge d’espace domine très nettement. Elle limite l’intensité et plus particulièrement la brillance du faisceau. En revanche, à des vitesses proches de la vitesse de la lumière, les deux effets se compensent. À l’échelle du laboratoire, en statique, on sait réaliser des champs électriques de l’ordre de 1 MV/m, des inductions magnétiques de l’ordre de 1 tesla.En reportant ces ordres de grandeurs dans l’équation de la dynamique:

Il est à noter que les distances focales dans les plans x et z de symétrie de la lentille sont de signe opposé: en d’autres termes, si la lentille focalise dans le plan x , elle défocalise dans le plan z .On peut combiner les deux effets de courbure et de focalisation dans un électroaimant unique de type dipolaire mais dont les pièces polaires ne sont pas parallèles. Une méthode différente consisterait à faire passer le faisceau décentré à travers un quadrupôle.L’optique des faisceaux de particules chargées dans un champ magnétique est semblable à l’optique des faisceaux lumineux. Les prismes de l’optique classique sont remplacés par les dipôles magnétiques, les lentilles par les quadrupôles magnétiques. On retrouve l’équivalent de la dispersion chromatique à la sortie d’un prisme, l’équivalent des aberrations liées aux défauts de réalisation des éléments optiques, etc.Il est important de signaler que le champ électromagnétique effectif qui agit sur une particule a deux origines: le champ extérieur qu’on applique pour guider et accélérer le faisceau par l’intermédiaire d’électroaimants et de tensions, d’une part, et le champ propre du faisceau lui-même, d’autre part. Ce dernier, appelé champ de charge d’espace, a une composante électrique défocalisante (répulsion coulombienne de particules de même charge) et une composante magnétique focalisante (les charges en mouvement constituant un courant qui génère un champ magnétique). À basse vitesse, et principalement au niveau de la source, la force électrique du champ de charge d’espace domine très nettement. Elle limite l’intensité et plus particulièrement la brillance du faisceau. En revanche, à des vitesses proches de la vitesse de la lumière, les deux effets se compensent. À l’échelle du laboratoire, en statique, on sait réaliser des champs électriques de l’ordre de 1 MV/m, des inductions magnétiques de l’ordre de 1 tesla.En reportant ces ordres de grandeurs dans l’équation de la dynamique: on voit que, pour des particules ultrarelativistes, v 年 c = 3 憐 108 m/s, un champ magnétique de 1 tesla est trois cents fois plus efficace qu’un champ électrique de 1 MV/m.Pour transporter un faisceau de haute énergie, on utilise exclusivement des champs magnétiques. Ce n’est qu’aux très basses vitesses, en dessous de:

on voit que, pour des particules ultrarelativistes, v 年 c = 3 憐 108 m/s, un champ magnétique de 1 tesla est trois cents fois plus efficace qu’un champ électrique de 1 MV/m.Pour transporter un faisceau de haute énergie, on utilise exclusivement des champs magnétiques. Ce n’est qu’aux très basses vitesses, en dessous de: soit environ 5 ke V/A pour un ion, que les solutions électriques de guidage présentent un intérêt.Caractéristiques d’un faisceau de particulesLes particules accélérées forment un faisceau caractérisé par:– Le type de particules qui le constituent (e -, p , d , 見, ion lourd, H-, etc., ou encore e +, p -, etc.).– L’intensité I proportionnelle au nombre de particules accélérées par seconde.– Le cycle utile qui définit la fraction de temps pendant laquelle le faisceau est effectivement utilisable pour la physique; c’est un paramètre essentiel pour les accélérateurs pulsés, d’une part, les accélérateurs dont le faisceau présente une microstructure RF, d’autre part.– L’émittance. Toutes les particules constituant le faisceau ne décrivent pas obligatoirement la même trajectoire; elles terminent leur accélération plus ou moins dispersées dans l’espace à six dimensions qui permet de les repérer: trois coordonnées de position (s ou t , coordonnée longitudinale; x ou z , les coordonnées transversales); trois coordonnées de pente associées ( face="EU Updot" 浪 ou face="EU Updot" 狼 , face="EU Updot" 來 ou face="EU Updot" 勞 qui définissent la divergence). L’origine du repère est attachée au centre de gravité du faisceau. L’émittance est alors définie en projection dans chacun des trois plans de l’espace des phases [s , face="EU Updot" 浪 ], [x , face="EU Updot" 來 ], [z , face="EU Updot" 勞 ]. C’est un ensemble de trois valeurs numériques (une par espace de phase) représentant l’aire inscrite dans un contour renfermant par exemple 95 p. 100 des particules. Pour les deux espaces transverses [x , face="EU Updot" 來 ], [z , face="EU Updot" 勞 ], l’unité utilisée est en général le millimètre 憐 milliradian (mm . mrad). Pour l’espace longitudinal, il existe différentes unités (eV . rad, eV . s, etc.). Remarquons que la coordonnée face="EU Updot" 浪 mesure la dispersion en énergie.Lorsqu’on accélère un faisceau, on augmente la quantité de mouvement longitudinale p s en laissant inchangées les quantités de mouvement transverses p x et p z . De ce fait, on diminue automatiquement les pentes:

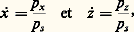

soit environ 5 ke V/A pour un ion, que les solutions électriques de guidage présentent un intérêt.Caractéristiques d’un faisceau de particulesLes particules accélérées forment un faisceau caractérisé par:– Le type de particules qui le constituent (e -, p , d , 見, ion lourd, H-, etc., ou encore e +, p -, etc.).– L’intensité I proportionnelle au nombre de particules accélérées par seconde.– Le cycle utile qui définit la fraction de temps pendant laquelle le faisceau est effectivement utilisable pour la physique; c’est un paramètre essentiel pour les accélérateurs pulsés, d’une part, les accélérateurs dont le faisceau présente une microstructure RF, d’autre part.– L’émittance. Toutes les particules constituant le faisceau ne décrivent pas obligatoirement la même trajectoire; elles terminent leur accélération plus ou moins dispersées dans l’espace à six dimensions qui permet de les repérer: trois coordonnées de position (s ou t , coordonnée longitudinale; x ou z , les coordonnées transversales); trois coordonnées de pente associées ( face="EU Updot" 浪 ou face="EU Updot" 狼 , face="EU Updot" 來 ou face="EU Updot" 勞 qui définissent la divergence). L’origine du repère est attachée au centre de gravité du faisceau. L’émittance est alors définie en projection dans chacun des trois plans de l’espace des phases [s , face="EU Updot" 浪 ], [x , face="EU Updot" 來 ], [z , face="EU Updot" 勞 ]. C’est un ensemble de trois valeurs numériques (une par espace de phase) représentant l’aire inscrite dans un contour renfermant par exemple 95 p. 100 des particules. Pour les deux espaces transverses [x , face="EU Updot" 來 ], [z , face="EU Updot" 勞 ], l’unité utilisée est en général le millimètre 憐 milliradian (mm . mrad). Pour l’espace longitudinal, il existe différentes unités (eV . rad, eV . s, etc.). Remarquons que la coordonnée face="EU Updot" 浪 mesure la dispersion en énergie.Lorsqu’on accélère un faisceau, on augmente la quantité de mouvement longitudinale p s en laissant inchangées les quantités de mouvement transverses p x et p z . De ce fait, on diminue automatiquement les pentes: et les émittances diminuent dans le rapport des impulsions longitudinales. L’accélération a un effet amortissant.Il existe divers types d’accélérateurs. Nous passerons en revue les principaux: accélérateurs statiques, cyclotrons, linéaires, machines circulaires.2. Les accélérateurs statiquesLe premier accélérateurHistoriquement, le premier accélérateur est le tube de Crookes, inventé dès 1895. Une ampoule de verre dans laquelle on a fait le vide contient une cathode chauffée (source thermo-ionique d’électrons). En face d’elle, une plaque de métal anode, portée à un potentiel positif, attire les électrons qui la frappent et lui font émettre des rayons X (fig. 5).Le Cockcroft-WaltonLes deux physiciens britanniques John Douglas Cockcroft et Ernest Thomas Sinton Walton obtiennent en 1932 la première désintégration atomique provoquée par des particules artificiellement accélérées. Les protons issus d’une source à ions sont accélérés à l’intérieur d’un tube isolant sous vide dont le sommet, où se trouve la source, est porté à un potentiel de 700 kV par rapport au sol. Arrivés en bas, les protons ont acquis une énergie de 700 keV suffisante pour transmuter du 7Li en deux noyaux d’hélium.Dans le montage d’origine, la haute tension est obtenue en redressant une tension alternative et en l’amplifiant par une série de condensateurs. Il existe de nombreux Cockcroft-Walton auprès des accélérateurs. Ils ne sont plus utilisés pour faire des expériences de physique mais plutôt pour préaccélérer le faisceau de particules, qui est repris ensuite par les autres étages de l’accélérateur. Les plus puissants Cockcroft-Walton montent jusqu’à environ 2 MV.Le Van de GraafDans l’appareil de Van de Graaf (1930), on applique les principes de base de l’électrostatique. Les charges électriques sont transportées par une courroie qui les ramasse au sol et va les déposer à l’intérieur d’une électrode élevée et bien isolée. À mesure que les charges s’accumulent, le potentiel de l’électrode supérieure monte. La tenue en tension est favorisée par une atmosphère de gaz inerte sous pression (SF6, 2, etc.). Les performances maximales se situent aux environs de 7 MV.Il y a eu jusqu’à environ trois cents machines de ce type en activité. On y accélérait des e -, p , d , ions lourds. Elles ont été abandonnées peu à peu, pour de nouveaux types d’accélérateurs.Le Van de Graaf-tandemPour monter en énergie, on peut accoupler deux colonnes isolantes. Un ion négatif, au potentiel du sol, injecté d’un côté, est attiré jusqu’à l’électrode haute tension. À la traversée de cette électrode, on lui arrache un nombre variable d’électrons pour le charger positivement. Continuant son chemin, l’ion est maintenant repoussé par le terminal haute tension et est accéléré vers la sortie opposée à la source. Les sources d’ions négatifs sont moins intenses que les sources d’ions positifs; néanmoins, grâce à ce montage, on gagne en énergie en doublant les dimensions de la machine (fig. 6).Une des limites essentielles de ces machines est bien évidemment la tenue en tension, qui pose de multiples problèmes technologiques. Il importe d’éviter les claquages qui détériorent la structure. La forme et la disposition des électrodes sont primordiales. Au C.R.N. (centre de recherche nucléaire) de Strasbourg, on construit une machine qui doit établir un record de ce point de vue en atteignant 35 MV. Une autre voie pour augmenter l’énergie finale consiste à accoupler au tandem un postaccélérateur. C’est le principe adopté à Saclay, où la machine principale est suivie d’une série de cavités supraconductrices.3. Les cyclotronsPrincipe des cyclotrons classiquesOn a vu que pour accélérer des particules, à l’énergie W, il suffisait d’établir une différence de potentiel V = W/q entre la source et l’électrode de masse. Malheureusement, il est pratiquement impossible d’envisager des accélérateurs statiques fournissant des tensions V supérieures à quelques dizaines de mégavolts.Dans le cyclotron, la solution adoptée est la traversée par des ions, un grand nombre de fois, de la même différence de potentiel (beaucoup plus faible il est vrai: quelques centaines de kilovolts), en tirant parti de la possibilité qu’offre un aimant dipolaire d’amener les particules chargées sur une trajectoire circulaire.Un cyclotron est donc constitué d’un dipôle circulaire entre les pôles duquel on place deux électrodes portées à haute tension (fig. 7). La source est au centre de l’aimant. Lorsqu’une particule chargée positivement est émise par la source (fig. 8), elle est, par exemple, attirée par l’électrode 1 si celle-ci est portée à un potentiel négatif par rapport à l’électrode 2. Elle effectue ensuite un demi-tour et elle est de nouveau accélérée, cette fois en direction de l’électrode 2 si celle-ci est, à ce moment, portée à un potentiel négatif par rapport à l’électrode 1. Ainsi, à chaque demi-tour, est-il nécessaire que le signe de la tension interélectrode s’inverse pour que la particule cumule les effets accélérateurs du champ électrique. Une tension alternative est donc utilisée.Au fur et à mesure que l’énergie, et donc la vitesse des particules, augmente, ces dernières décrivent des cercles de rayon r croissant:

et les émittances diminuent dans le rapport des impulsions longitudinales. L’accélération a un effet amortissant.Il existe divers types d’accélérateurs. Nous passerons en revue les principaux: accélérateurs statiques, cyclotrons, linéaires, machines circulaires.2. Les accélérateurs statiquesLe premier accélérateurHistoriquement, le premier accélérateur est le tube de Crookes, inventé dès 1895. Une ampoule de verre dans laquelle on a fait le vide contient une cathode chauffée (source thermo-ionique d’électrons). En face d’elle, une plaque de métal anode, portée à un potentiel positif, attire les électrons qui la frappent et lui font émettre des rayons X (fig. 5).Le Cockcroft-WaltonLes deux physiciens britanniques John Douglas Cockcroft et Ernest Thomas Sinton Walton obtiennent en 1932 la première désintégration atomique provoquée par des particules artificiellement accélérées. Les protons issus d’une source à ions sont accélérés à l’intérieur d’un tube isolant sous vide dont le sommet, où se trouve la source, est porté à un potentiel de 700 kV par rapport au sol. Arrivés en bas, les protons ont acquis une énergie de 700 keV suffisante pour transmuter du 7Li en deux noyaux d’hélium.Dans le montage d’origine, la haute tension est obtenue en redressant une tension alternative et en l’amplifiant par une série de condensateurs. Il existe de nombreux Cockcroft-Walton auprès des accélérateurs. Ils ne sont plus utilisés pour faire des expériences de physique mais plutôt pour préaccélérer le faisceau de particules, qui est repris ensuite par les autres étages de l’accélérateur. Les plus puissants Cockcroft-Walton montent jusqu’à environ 2 MV.Le Van de GraafDans l’appareil de Van de Graaf (1930), on applique les principes de base de l’électrostatique. Les charges électriques sont transportées par une courroie qui les ramasse au sol et va les déposer à l’intérieur d’une électrode élevée et bien isolée. À mesure que les charges s’accumulent, le potentiel de l’électrode supérieure monte. La tenue en tension est favorisée par une atmosphère de gaz inerte sous pression (SF6, 2, etc.). Les performances maximales se situent aux environs de 7 MV.Il y a eu jusqu’à environ trois cents machines de ce type en activité. On y accélérait des e -, p , d , ions lourds. Elles ont été abandonnées peu à peu, pour de nouveaux types d’accélérateurs.Le Van de Graaf-tandemPour monter en énergie, on peut accoupler deux colonnes isolantes. Un ion négatif, au potentiel du sol, injecté d’un côté, est attiré jusqu’à l’électrode haute tension. À la traversée de cette électrode, on lui arrache un nombre variable d’électrons pour le charger positivement. Continuant son chemin, l’ion est maintenant repoussé par le terminal haute tension et est accéléré vers la sortie opposée à la source. Les sources d’ions négatifs sont moins intenses que les sources d’ions positifs; néanmoins, grâce à ce montage, on gagne en énergie en doublant les dimensions de la machine (fig. 6).Une des limites essentielles de ces machines est bien évidemment la tenue en tension, qui pose de multiples problèmes technologiques. Il importe d’éviter les claquages qui détériorent la structure. La forme et la disposition des électrodes sont primordiales. Au C.R.N. (centre de recherche nucléaire) de Strasbourg, on construit une machine qui doit établir un record de ce point de vue en atteignant 35 MV. Une autre voie pour augmenter l’énergie finale consiste à accoupler au tandem un postaccélérateur. C’est le principe adopté à Saclay, où la machine principale est suivie d’une série de cavités supraconductrices.3. Les cyclotronsPrincipe des cyclotrons classiquesOn a vu que pour accélérer des particules, à l’énergie W, il suffisait d’établir une différence de potentiel V = W/q entre la source et l’électrode de masse. Malheureusement, il est pratiquement impossible d’envisager des accélérateurs statiques fournissant des tensions V supérieures à quelques dizaines de mégavolts.Dans le cyclotron, la solution adoptée est la traversée par des ions, un grand nombre de fois, de la même différence de potentiel (beaucoup plus faible il est vrai: quelques centaines de kilovolts), en tirant parti de la possibilité qu’offre un aimant dipolaire d’amener les particules chargées sur une trajectoire circulaire.Un cyclotron est donc constitué d’un dipôle circulaire entre les pôles duquel on place deux électrodes portées à haute tension (fig. 7). La source est au centre de l’aimant. Lorsqu’une particule chargée positivement est émise par la source (fig. 8), elle est, par exemple, attirée par l’électrode 1 si celle-ci est portée à un potentiel négatif par rapport à l’électrode 2. Elle effectue ensuite un demi-tour et elle est de nouveau accélérée, cette fois en direction de l’électrode 2 si celle-ci est, à ce moment, portée à un potentiel négatif par rapport à l’électrode 1. Ainsi, à chaque demi-tour, est-il nécessaire que le signe de la tension interélectrode s’inverse pour que la particule cumule les effets accélérateurs du champ électrique. Une tension alternative est donc utilisée.Au fur et à mesure que l’énergie, et donc la vitesse des particules, augmente, ces dernières décrivent des cercles de rayon r croissant: La fréquence de révolution:

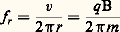

La fréquence de révolution: est indépendante de la vitesse, le mouvement est isochrone et c’est une tension alternative à fréquence f r constante qu’il convient d’appliquer. On peut aussi choisir f RF = hf r , c’est-à-dire travailler sur un harmonique h de la fréquence de révolution. Pour des raisons pratiques évidentes, h est choisi afin que la fréquence tombe dans la gamme radiofréquence (RF). Nous remarquerons que les particules ne peuvent être accélérées que pendant une demi-période dans un sens de rotation donné. Si, de plus, on veut limiter la dispersion en énergie du faisceau accéléré, il est nécessaire de n’accepter qu’une petite extension en phase RF, 﨏 de quelques degrés. À la sortie de l’accélérateur, le faisceau présente une structure à la fréquence f RF. Le cycle utile est d’environ 1/360.Lorsqu’on étudie de façon plus approfondie le mouvement des particules dans un cyclotron, on voit apparaître deux problèmes:– pour assurer la focalisation verticale du faisceau, il est indispensable que le champ magnétique décroisse avec le rayon r ;– assez vite, lorsque l’énergie des particules croît, les effets relativistes font que la masse m des particules augmente.Pour ces deux raisons, d’après la relation:

est indépendante de la vitesse, le mouvement est isochrone et c’est une tension alternative à fréquence f r constante qu’il convient d’appliquer. On peut aussi choisir f RF = hf r , c’est-à-dire travailler sur un harmonique h de la fréquence de révolution. Pour des raisons pratiques évidentes, h est choisi afin que la fréquence tombe dans la gamme radiofréquence (RF). Nous remarquerons que les particules ne peuvent être accélérées que pendant une demi-période dans un sens de rotation donné. Si, de plus, on veut limiter la dispersion en énergie du faisceau accéléré, il est nécessaire de n’accepter qu’une petite extension en phase RF, 﨏 de quelques degrés. À la sortie de l’accélérateur, le faisceau présente une structure à la fréquence f RF. Le cycle utile est d’environ 1/360.Lorsqu’on étudie de façon plus approfondie le mouvement des particules dans un cyclotron, on voit apparaître deux problèmes:– pour assurer la focalisation verticale du faisceau, il est indispensable que le champ magnétique décroisse avec le rayon r ;– assez vite, lorsque l’énergie des particules croît, les effets relativistes font que la masse m des particules augmente.Pour ces deux raisons, d’après la relation: la fréquence de rotation des particules diminue au fur et à mesure de l’accélération. Si donc on maintient f RF constante, on s’éloigne peu à peu de l’isochronisme en se décalant sur l’onde RF et l’efficacité de l’accélération décroît. C’est la limitation essentielle des cyclotrons classiques, les particules ne pouvant y effectuer qu’un nombre limité de tours.Les cyclotrons isochronesPour augmenter l’énergie du faisceau extrait tout en conservant l’isochronisme, il faut une loi:

la fréquence de rotation des particules diminue au fur et à mesure de l’accélération. Si donc on maintient f RF constante, on s’éloigne peu à peu de l’isochronisme en se décalant sur l’onde RF et l’efficacité de l’accélération décroît. C’est la limitation essentielle des cyclotrons classiques, les particules ne pouvant y effectuer qu’un nombre limité de tours.Les cyclotrons isochronesPour augmenter l’énergie du faisceau extrait tout en conservant l’isochronisme, il faut une loi: quel que soit r ; c’est-à-dire accroître l’induction parallèlement à l’augmentation de la masse m pour les rayons r croissants. Bien évidemment, ce procédé va à l’encontre de la focalisation verticale et implique la rupture de la symétrie cylindrique du cyclotron classique pour pouvoir introduire les forces de focalisation verticales sur le faisceau.Une des méthodes envisageables est la création de zones de champ fort et de zones de champ faible le long des trajectoires, qui ne sont plus tout à fait circulaires. On obtient des cyclotrons à secteurs, avec des collines et des vallées. À la limite, on obtient des cyclotrons à secteurs séparés dans lesquels on a complètement supprimé les zones de champ faible des vallées (fig. 9).Dans les cyclotrons à secteurs séparés, ou C.S.S., les secteurs ne s’étendent pas jusqu’au centre de la machine. Les espaces entre secteurs (fig. 10) sont alors utilisés pour:– injecter, axialement, les particules (préaccélérées après extraction de la source) sur le rayon correspondant au premier tour;– placer les aimants d’extraction;– introduire les électrodes d’accélération.Ces problèmes d’isochronisme sont moins sévères lorsqu’on se limite au domaine des basses vitesses. Les cyclotrons représentent donc des machines idéales pour accélérer des particules lourdes ou très lourdes, comme les ions lourds.On caractérise un cyclotron par le paramètre K défini par:

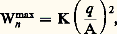

quel que soit r ; c’est-à-dire accroître l’induction parallèlement à l’augmentation de la masse m pour les rayons r croissants. Bien évidemment, ce procédé va à l’encontre de la focalisation verticale et implique la rupture de la symétrie cylindrique du cyclotron classique pour pouvoir introduire les forces de focalisation verticales sur le faisceau.Une des méthodes envisageables est la création de zones de champ fort et de zones de champ faible le long des trajectoires, qui ne sont plus tout à fait circulaires. On obtient des cyclotrons à secteurs, avec des collines et des vallées. À la limite, on obtient des cyclotrons à secteurs séparés dans lesquels on a complètement supprimé les zones de champ faible des vallées (fig. 9).Dans les cyclotrons à secteurs séparés, ou C.S.S., les secteurs ne s’étendent pas jusqu’au centre de la machine. Les espaces entre secteurs (fig. 10) sont alors utilisés pour:– injecter, axialement, les particules (préaccélérées après extraction de la source) sur le rayon correspondant au premier tour;– placer les aimants d’extraction;– introduire les électrodes d’accélération.Ces problèmes d’isochronisme sont moins sévères lorsqu’on se limite au domaine des basses vitesses. Les cyclotrons représentent donc des machines idéales pour accélérer des particules lourdes ou très lourdes, comme les ions lourds.On caractérise un cyclotron par le paramètre K défini par: où Wn max est l’énergie par nucléon maximale atteinte, q le nombre de charges de l’ion et A le nombre de masse de l’ion.L’expression de K est ainsi:

où Wn max est l’énergie par nucléon maximale atteinte, q le nombre de charges de l’ion et A le nombre de masse de l’ion.L’expression de K est ainsi: où Bmax est l’induction maximale, R le rayon moyen de la trajectoire d’extraction et mn la masse d’un nucléon.Les cyclotrons isochrones, et plus particulièrement les C.S.S., sont des machines souples, bien adaptées à l’accélération de faisceaux d’ions lourds, ayant la possibilité de fonctionner à énergie variable. Pour obtenir des faisceaux de haute énergie, on accouple en série plusieurs cyclotrons avec des échanges de charges entre les différents étages.Il existe un très grand nombre de cyclotrons en service dans le monde. Certains sont dédiés à l’accélération de faisceaux intenses, de 0,2 à 2,0 mA, de protons à 500-600 MeV. Ce sont des usines à faisceaux secondaires de mésons 神 et 猪 comme le S.I.N. (Schweizerisches Institut für Nuklearforschung) de Zurich ou Triumf à Vancouver. D’autres sont dédiés à la production de faisceaux d’ions lourds; c’est le cas de S.A.R.A. (système d’accélérateur Rhône-Alpes) à Grenoble et G.A.N.I.L. (grand accélérateur national d’ions lourds) à Caen.La tendance actuelle est à l’utilisation de champs intenses. Derniers-nés de la technique, plusieurs cyclotrons isochrones compacts à aimants supraconducteurs, dont les performances nominales sont dans la gamme de celles de G.A.N.I.L., viennent de démarrer ou sont en construction. Dans le volume cylindrique d’un champ de l’ordre de 5 teslas créé par des enroulements circulaires supraconducteurs, les pièces magnétiques, totalement saturées, créent la modulation de champ. La technologie est rendue délicate par les contraintes cryogéniques et mécaniques, mais aussi par les difficultés d’implanter les organes annexes d’injection et d’extraction.Du point de vue des intensités délivrées, les performances de pointe se situent dans la gamme de 1013 ions par seconde pour les ions légers et environ cent fois moins pour les ions les plus lourds (fig. 11).Les premiers cyclotrons sont apparus dans les années 1930. Le principe et l’essentiel des techniques classiques mises en jeu sont bien connus. Plusieurs compagnies, comme la C.G.R.-MeV (Compagnie générale de radiologie) à Buc, proposent sur catalogue un éventail de machines qu’elles peuvent livrer clés en main. Elles fournissent des laboratoires de recherche en physique nucléaire. Toutefois, la plus grosse partie de leur production est destinée à satisfaire des besoins non nucléaires: physique du solide (implantation); médecine (thérapie du cancer); radioéléments artificiels (recherches métaboliques et pharmacologiques); conservation (produits alimentaires); stérilisation (appareils chirurgicaux); chimie (polymérisation des matières plastiques); analyses métallurgiques (étude de défauts, érosion, migration, perméation...); analyses écologiques (pollution); analyses archéologiques (datation).Le cyclotron est le type d’accélérateur le plus utilisé pour des applications pratiques.4. Les accélérateurs linéairesPrincipes de base des linéaires à protons et ions lourdsSoit une série de tubes cylindriques creux A1, B1, A2, B2, A3, etc., dans l’axe desquels on envoie un faisceau de particules issues de la source K. Si on applique aux tubes une tension alternative, il existera, entre deux tubes successifs, une tension alternative qui sera tantôt accélératrice, tantôt décélératrice.Il ne saurait être question d’accélérer un faisceau continu. En revanche, il devient possible pour certaines particules de subir une succession d’accélérations si elles passent toujours dans les intervalles entre tubes lorsque la phase du champ électrique est favorable. La présence de ces tubes dits de glissement soustrait les particules à tout champ électrique lorsque celui-ci est de freinage.En quelque sorte, nous venons de dérouler l’orbite d’un cyclotron. Par analogie, pour conserver le synchronisme entre les particules accélérées et le champ accélérateur, il faut des tubes de glissement de plus en plus longs le long de la structure (on circulait sur les orbites de rayon r croissant dans le cyclotron).Synchronisme et oscillations de phasesPour que la particule de référence reste synchrone de la radiofréquence, c’est-à-dire traverse les gaps accélérateurs successifs au même niveau V0 de la tension, il est nécessaire que la longueur L du tube de glissement, la période T de la RF et la vitesse v de la particule vérifient:

où Bmax est l’induction maximale, R le rayon moyen de la trajectoire d’extraction et mn la masse d’un nucléon.Les cyclotrons isochrones, et plus particulièrement les C.S.S., sont des machines souples, bien adaptées à l’accélération de faisceaux d’ions lourds, ayant la possibilité de fonctionner à énergie variable. Pour obtenir des faisceaux de haute énergie, on accouple en série plusieurs cyclotrons avec des échanges de charges entre les différents étages.Il existe un très grand nombre de cyclotrons en service dans le monde. Certains sont dédiés à l’accélération de faisceaux intenses, de 0,2 à 2,0 mA, de protons à 500-600 MeV. Ce sont des usines à faisceaux secondaires de mésons 神 et 猪 comme le S.I.N. (Schweizerisches Institut für Nuklearforschung) de Zurich ou Triumf à Vancouver. D’autres sont dédiés à la production de faisceaux d’ions lourds; c’est le cas de S.A.R.A. (système d’accélérateur Rhône-Alpes) à Grenoble et G.A.N.I.L. (grand accélérateur national d’ions lourds) à Caen.La tendance actuelle est à l’utilisation de champs intenses. Derniers-nés de la technique, plusieurs cyclotrons isochrones compacts à aimants supraconducteurs, dont les performances nominales sont dans la gamme de celles de G.A.N.I.L., viennent de démarrer ou sont en construction. Dans le volume cylindrique d’un champ de l’ordre de 5 teslas créé par des enroulements circulaires supraconducteurs, les pièces magnétiques, totalement saturées, créent la modulation de champ. La technologie est rendue délicate par les contraintes cryogéniques et mécaniques, mais aussi par les difficultés d’implanter les organes annexes d’injection et d’extraction.Du point de vue des intensités délivrées, les performances de pointe se situent dans la gamme de 1013 ions par seconde pour les ions légers et environ cent fois moins pour les ions les plus lourds (fig. 11).Les premiers cyclotrons sont apparus dans les années 1930. Le principe et l’essentiel des techniques classiques mises en jeu sont bien connus. Plusieurs compagnies, comme la C.G.R.-MeV (Compagnie générale de radiologie) à Buc, proposent sur catalogue un éventail de machines qu’elles peuvent livrer clés en main. Elles fournissent des laboratoires de recherche en physique nucléaire. Toutefois, la plus grosse partie de leur production est destinée à satisfaire des besoins non nucléaires: physique du solide (implantation); médecine (thérapie du cancer); radioéléments artificiels (recherches métaboliques et pharmacologiques); conservation (produits alimentaires); stérilisation (appareils chirurgicaux); chimie (polymérisation des matières plastiques); analyses métallurgiques (étude de défauts, érosion, migration, perméation...); analyses écologiques (pollution); analyses archéologiques (datation).Le cyclotron est le type d’accélérateur le plus utilisé pour des applications pratiques.4. Les accélérateurs linéairesPrincipes de base des linéaires à protons et ions lourdsSoit une série de tubes cylindriques creux A1, B1, A2, B2, A3, etc., dans l’axe desquels on envoie un faisceau de particules issues de la source K. Si on applique aux tubes une tension alternative, il existera, entre deux tubes successifs, une tension alternative qui sera tantôt accélératrice, tantôt décélératrice.Il ne saurait être question d’accélérer un faisceau continu. En revanche, il devient possible pour certaines particules de subir une succession d’accélérations si elles passent toujours dans les intervalles entre tubes lorsque la phase du champ électrique est favorable. La présence de ces tubes dits de glissement soustrait les particules à tout champ électrique lorsque celui-ci est de freinage.En quelque sorte, nous venons de dérouler l’orbite d’un cyclotron. Par analogie, pour conserver le synchronisme entre les particules accélérées et le champ accélérateur, il faut des tubes de glissement de plus en plus longs le long de la structure (on circulait sur les orbites de rayon r croissant dans le cyclotron).Synchronisme et oscillations de phasesPour que la particule de référence reste synchrone de la radiofréquence, c’est-à-dire traverse les gaps accélérateurs successifs au même niveau V0 de la tension, il est nécessaire que la longueur L du tube de glissement, la période T de la RF et la vitesse v de la particule vérifient: Le niveau de tension dans le gap qui va communiquer l’énergie q V0 à la particule et changer sa vitesse v est obtenu à deux instants t M1 et t N1 par période RF (fig. 12 a). Si seules les particules passant rigoureusement à ces instants étaient correctement accélérées, leur nombre serait infiniment petit. Mais analysons qualitativement ce qui se passe pour des particules passant à des instants voisins de t M1: t P et t P size=1 par exemple. Une particule arrivant en P est en avance sur la référence M1; or elle est en présence d’une tension accélératrice inférieure à V0. Elle sera donc moins accélérée que la particule de référence et compensera partiellement son écart en temps pour se rapprocher de la référence. La particule P , en retard, voit une tension plus élevée et tendra à rattraper ce retard. On a donc, autour de M1, M2, ..., une zone de stabilité de l’accélération. En revanche, on prouverait facilement qu’autour des point 1, 2, ..., l’accélération est instable.Dans l’espace des phases longitudinal (fig. 12 b), avec la phase RF 﨏 en abscisse et l’écart en énergie W en ordonnée, cela se traduit par l’existence d’une zone de stabilité, centrée sur le point M1 pris comme origine des axes de coordonnées et limitée par une séparatrice (courbe 1). Les trajectoires 4 et 5 extérieures à la séparatrice correspondent à des conditions instables. Les petites oscillations à l’intérieur correspondent à des oscillations harmoniques de petite amplitude (courbe 3). Le point double de la séparatrice sur l’axe 﨏 à 漣 2 﨏s correspond au point 1, qui est un point fixe instable dans cet espace.Les structures accélératrices pour protonsIl est possible de décrire la structure des cavités Alvarez utilisées pour accélérer les protons, à partir d’une cavité cylindrique circulaire résonnant sur le mode E010. Le champ électrique longitudinal est alors maximal sur l’axe.On dispose autour de l’axe les tubes de glissement. Loin de l’axe, le champ est peu déformé. Au voisinage de l’axe, il se confine entre les tubes de glissement sans pénétrer profondement à l’intérieur (fig. 13).Ces structures ont été optimisées pour travailler à des fréquences de l’ordre de 200 MHz. On arrive, en moyenne, à obtenir des taux d’accélération d’environ 1 MV/m.Mouvement transversalConsidérons le champ dans le gap entre deux tubes de glissement (fig. 14). Le champ électrique a une composante focalisante à l’entrée du gap, défocalisante à la sortie. En moyenne, on pourrait penser que le bilan global est nul. En fait, la tension RF croît pendant le temps de transit à travers le gap lorsqu’on est accroché sur le point stable M1, et donc la résultante est défocalisante. On est sensiblement ramené au problème rencontré dans les cyclotrons avec la focalisation verticale.Dans ce cas particulier, le problème se résout en insérant une focalisation quadrupolaire magnétique alternée à l’intérieur des tubes de glissement. Cependant, en début de structure, la vitesse des particules est faible. Ces lentilles quadrupolaires magnétiques sont peu efficaces:

Le niveau de tension dans le gap qui va communiquer l’énergie q V0 à la particule et changer sa vitesse v est obtenu à deux instants t M1 et t N1 par période RF (fig. 12 a). Si seules les particules passant rigoureusement à ces instants étaient correctement accélérées, leur nombre serait infiniment petit. Mais analysons qualitativement ce qui se passe pour des particules passant à des instants voisins de t M1: t P et t P size=1 par exemple. Une particule arrivant en P est en avance sur la référence M1; or elle est en présence d’une tension accélératrice inférieure à V0. Elle sera donc moins accélérée que la particule de référence et compensera partiellement son écart en temps pour se rapprocher de la référence. La particule P , en retard, voit une tension plus élevée et tendra à rattraper ce retard. On a donc, autour de M1, M2, ..., une zone de stabilité de l’accélération. En revanche, on prouverait facilement qu’autour des point 1, 2, ..., l’accélération est instable.Dans l’espace des phases longitudinal (fig. 12 b), avec la phase RF 﨏 en abscisse et l’écart en énergie W en ordonnée, cela se traduit par l’existence d’une zone de stabilité, centrée sur le point M1 pris comme origine des axes de coordonnées et limitée par une séparatrice (courbe 1). Les trajectoires 4 et 5 extérieures à la séparatrice correspondent à des conditions instables. Les petites oscillations à l’intérieur correspondent à des oscillations harmoniques de petite amplitude (courbe 3). Le point double de la séparatrice sur l’axe 﨏 à 漣 2 﨏s correspond au point 1, qui est un point fixe instable dans cet espace.Les structures accélératrices pour protonsIl est possible de décrire la structure des cavités Alvarez utilisées pour accélérer les protons, à partir d’une cavité cylindrique circulaire résonnant sur le mode E010. Le champ électrique longitudinal est alors maximal sur l’axe.On dispose autour de l’axe les tubes de glissement. Loin de l’axe, le champ est peu déformé. Au voisinage de l’axe, il se confine entre les tubes de glissement sans pénétrer profondement à l’intérieur (fig. 13).Ces structures ont été optimisées pour travailler à des fréquences de l’ordre de 200 MHz. On arrive, en moyenne, à obtenir des taux d’accélération d’environ 1 MV/m.Mouvement transversalConsidérons le champ dans le gap entre deux tubes de glissement (fig. 14). Le champ électrique a une composante focalisante à l’entrée du gap, défocalisante à la sortie. En moyenne, on pourrait penser que le bilan global est nul. En fait, la tension RF croît pendant le temps de transit à travers le gap lorsqu’on est accroché sur le point stable M1, et donc la résultante est défocalisante. On est sensiblement ramené au problème rencontré dans les cyclotrons avec la focalisation verticale.Dans ce cas particulier, le problème se résout en insérant une focalisation quadrupolaire magnétique alternée à l’intérieur des tubes de glissement. Cependant, en début de structure, la vitesse des particules est faible. Ces lentilles quadrupolaires magnétiques sont peu efficaces: et nécessairement courtes puisque, simultanément, les tubes de glissement sont courts. Enfin, plus l’énergie d’injection est basse, plus les forces défocalisantes de charge d’espace sont intenses. On comprend donc que la plupart des phénomènes qui limitent les performances (intensité, émittance) se situent au niveau des toutes premières cellules. On comprend aussi la nécessité d’injecter à énergie assez élevée dans de telles machines.Les linéaires à protons existantsTous les grands accélérateurs circulaires à protons utilisent un linéaire comme injecteur. Le schéma est en principe le suivant:– Cockroft-Waton (400-1000 keV);– linéaire du type Alvarez (20-200 MeV);– accélérateur circulaire de type synchrotron.Lorsqu’ils servent d’injecteur, ces linéaires ont un cycle utile (rapport de la longueur de l’impulsion faisceau à l’intervalle séparant deux impulsions) très faible (face=F0019 麗 1/1000). Ils ne tirent que pendant l’injection dans la machine circulaire, c’est-à-dire t 諒 200 猪s. Des intensités de l’ordre de 100 mA peuvent être atteintes, et cela à des fréquences variant entre une fraction de hertz et quelques hertz.Le plus grand accélérateur à protons est le 800 MeV de Los Alamos. Il mesure 800 m et délivre un courant moyen de 600 猪A avec un cycle utile macroscopique de 10 p. 100.Les linéaires à ions lourdsLes problèmes de focalisation transverse à l’entrée d’un linéaire sont difficiles à résoudre pour les protons, et encore plus difficiles lorsqu’on considère des ions très lourds avec des valeurs de q /A forcément faibles. La vitesse de ces ions lourds est alors de l’ordre de dix fois plus faible que celle des protons sortant du même pré-injecteur. Il faut donc baisser la fréquence RF pour augmenter la longueur des tubes de glissement et pouvoir y introduire de la focalisation.Les premiers étages d’un linéaire à ions lourds sont donc des structures basses fréquences 黎 25 MHz du type Wideröe.Bien évidemment, dès que possible, on sort des étages Wideröe pour passer à des structures Alvarez à plus hautes fréquences, donc plus efficaces. L’efficacité est encore accrue par les nombreux échanges de charges intermédiaires que l’on fait subir aux particules.Il existe plusieurs linéaires à ions lourds à Berkeley, Yale, Kharkov, Manchester, Darmstadt..., tous dans la gamme des 10 MeV/A fournissant plusieurs microampères d’ions légers.Les structures R.F.Q. (Radio Frequency Quadrupole)Comme signalé auparavant, aux très basses vitesses, le champ électrique est efficace. En statique, les champs électriques que l’on sait tenir se situent aux environs de 1 MV/m. En revanche, en RF et à 200 MHz par exemple, on peut obtenir jusqu’à 30 MV/m, de sorte que le point de recouvrement entre les efficacités de focalisation magnétique et électrique se trouve repoussé à 廓 年 0,1, c’est-àdire au-delà des énergies classiques d’injection dans un linéaire à protons. D’où l’idée émise de réaliser l’accélération et la focalisation des faisceaux de basses vitesses par l’intermédiaire du seul champ électrique.L’analogue du quadrupôle magnétique est le quadrupôle électrique, avec un réseau d’équipotentielles électriques de formes hyperboliques tournées de 450 par rapport à leurs homologues magnétiques.Si l’on se contente d’une pure symétrie quadrupolaire, le champ électrique est purement transversal: il y a focalisation puis défocalisation au rythme de la RF. On sait qu’un doublet focalisant-défocalisant de même force donne un bilan macroscopique focalisant (principe du gradient alterné). On est donc assuré d’avoir une focalisation transverse de principe relativement forte. Néanmoins, le but étant d’accélérer le faisceau tout en maintenant la focalisation transverse, il faut créer une composante longitudinale de champ électrique. Pour ce faire, on module la distance entre pôles opposés avec une période longitudinale égale à la distance parcourue par la particule de référence en une période RF (fig. 15).Les linéaires R.F.Q. sont d’excellents injecteurs pour les linéaires classiques. Ils permettent simultanément:– d’abaisser considérablement le potentiel du terminal où se trouve la source (par exemple de 700 kV à 50 kV pour les protons);– de prégrouper avec un excellent rendement un faisceau intense (face=F0019 黎 100 mA pour des protons);– de l’accélérer dans de petites émittances jusqu’à l’énergie d’injection dans le linéaire classique.Bien évidemment, la fréquence RF du linéaire R.F.Q. doit être compatible avec la fréquence RF de l’étage supérieur: en général 200 MHz pour les structures Alvarez à protons et 25 MHz pour les structures Wideröe à ions lourds.Les linéaires à électronsPour les électrons, très vite, dès l’entrée, on a 隣 = v/c 年 1. Il n’est plus nécessaire d’introduire des tubes de glissement de longueur variable. Il n’existe pas d’oscillations de phase, mais plutôt un mouvement asymptotique d’accélération.Les structures sont des guides d’ondes cylindriques dans lesquels on ralentit la vitesse de phase par des iris. Elles fonctionnent à 3 000 MHz (les sources hyperfréquences ont été développées pendant la Seconde Guerre mondiale) et permettent des champs accélérateurs moyens de 10 MV/m, donc environ dix fois plus élevés que dans une structure Alvarez. La machine se présente comme une suite de tanks accélérateurs entre lesquels sont insérés des quadrupôles magnétiques pour focaliser le faisceau.Ces linéaires accélèrent aussi des positrons. Le schéma est alors le suivant. Dans la première partie de la machine, on accélère un faisceau intense d’électrons. Ce faisceau est ensuite focalisé sur un convertisseur, derrière lequel on récupère les positrons produits. La conversion électron-positron se fait en deux temps. Tout d’abord, le ralentissement brutal de l’électron dans une cible se fait par émission d’un flux intense de rayonnement 塚. Ces 塚 interagissent à leur tour avec une cible de béryllium pour donner naissance à une paire électron-positron. Le rendement de conversion est faible (face=F0019 麗 1/100). Le convertisseur est suivi d’une optique grande acceptance qui permet de récupérer le maximum de positrons. Ceux-ci sont portés à l’énergie voulue dans la suite de la structure.Comme pour les linéaires à protons, le cycle utile est faible (face=F0019 麗 1/1 000). Cela rend délicates certaines expériences dites à coïncidences, c’est-à-dire où l’on veut discerner la simultanéité de certains événements au milieu d’autres sans corrélation.Le plus grand accélérateur linéaire à électrons est la machine du S.L.A.C. (Stanford Linear Accelerator), à Stanford. Cette machine a 3,05 km de longueur. Au départ, elle permettait d’atteindre 25 GeV. Récemment, le gradient accélérateur a été doublé et l’énergie finale est passée à 50 GeV.Les linéaires à inductionVia les équations de Maxwell, en régime pulsé, champ électrique et champ magnétique sont indissociables:

et nécessairement courtes puisque, simultanément, les tubes de glissement sont courts. Enfin, plus l’énergie d’injection est basse, plus les forces défocalisantes de charge d’espace sont intenses. On comprend donc que la plupart des phénomènes qui limitent les performances (intensité, émittance) se situent au niveau des toutes premières cellules. On comprend aussi la nécessité d’injecter à énergie assez élevée dans de telles machines.Les linéaires à protons existantsTous les grands accélérateurs circulaires à protons utilisent un linéaire comme injecteur. Le schéma est en principe le suivant:– Cockroft-Waton (400-1000 keV);– linéaire du type Alvarez (20-200 MeV);– accélérateur circulaire de type synchrotron.Lorsqu’ils servent d’injecteur, ces linéaires ont un cycle utile (rapport de la longueur de l’impulsion faisceau à l’intervalle séparant deux impulsions) très faible (face=F0019 麗 1/1000). Ils ne tirent que pendant l’injection dans la machine circulaire, c’est-à-dire t 諒 200 猪s. Des intensités de l’ordre de 100 mA peuvent être atteintes, et cela à des fréquences variant entre une fraction de hertz et quelques hertz.Le plus grand accélérateur à protons est le 800 MeV de Los Alamos. Il mesure 800 m et délivre un courant moyen de 600 猪A avec un cycle utile macroscopique de 10 p. 100.Les linéaires à ions lourdsLes problèmes de focalisation transverse à l’entrée d’un linéaire sont difficiles à résoudre pour les protons, et encore plus difficiles lorsqu’on considère des ions très lourds avec des valeurs de q /A forcément faibles. La vitesse de ces ions lourds est alors de l’ordre de dix fois plus faible que celle des protons sortant du même pré-injecteur. Il faut donc baisser la fréquence RF pour augmenter la longueur des tubes de glissement et pouvoir y introduire de la focalisation.Les premiers étages d’un linéaire à ions lourds sont donc des structures basses fréquences 黎 25 MHz du type Wideröe.Bien évidemment, dès que possible, on sort des étages Wideröe pour passer à des structures Alvarez à plus hautes fréquences, donc plus efficaces. L’efficacité est encore accrue par les nombreux échanges de charges intermédiaires que l’on fait subir aux particules.Il existe plusieurs linéaires à ions lourds à Berkeley, Yale, Kharkov, Manchester, Darmstadt..., tous dans la gamme des 10 MeV/A fournissant plusieurs microampères d’ions légers.Les structures R.F.Q. (Radio Frequency Quadrupole)Comme signalé auparavant, aux très basses vitesses, le champ électrique est efficace. En statique, les champs électriques que l’on sait tenir se situent aux environs de 1 MV/m. En revanche, en RF et à 200 MHz par exemple, on peut obtenir jusqu’à 30 MV/m, de sorte que le point de recouvrement entre les efficacités de focalisation magnétique et électrique se trouve repoussé à 廓 年 0,1, c’est-àdire au-delà des énergies classiques d’injection dans un linéaire à protons. D’où l’idée émise de réaliser l’accélération et la focalisation des faisceaux de basses vitesses par l’intermédiaire du seul champ électrique.L’analogue du quadrupôle magnétique est le quadrupôle électrique, avec un réseau d’équipotentielles électriques de formes hyperboliques tournées de 450 par rapport à leurs homologues magnétiques.Si l’on se contente d’une pure symétrie quadrupolaire, le champ électrique est purement transversal: il y a focalisation puis défocalisation au rythme de la RF. On sait qu’un doublet focalisant-défocalisant de même force donne un bilan macroscopique focalisant (principe du gradient alterné). On est donc assuré d’avoir une focalisation transverse de principe relativement forte. Néanmoins, le but étant d’accélérer le faisceau tout en maintenant la focalisation transverse, il faut créer une composante longitudinale de champ électrique. Pour ce faire, on module la distance entre pôles opposés avec une période longitudinale égale à la distance parcourue par la particule de référence en une période RF (fig. 15).Les linéaires R.F.Q. sont d’excellents injecteurs pour les linéaires classiques. Ils permettent simultanément:– d’abaisser considérablement le potentiel du terminal où se trouve la source (par exemple de 700 kV à 50 kV pour les protons);– de prégrouper avec un excellent rendement un faisceau intense (face=F0019 黎 100 mA pour des protons);– de l’accélérer dans de petites émittances jusqu’à l’énergie d’injection dans le linéaire classique.Bien évidemment, la fréquence RF du linéaire R.F.Q. doit être compatible avec la fréquence RF de l’étage supérieur: en général 200 MHz pour les structures Alvarez à protons et 25 MHz pour les structures Wideröe à ions lourds.Les linéaires à électronsPour les électrons, très vite, dès l’entrée, on a 隣 = v/c 年 1. Il n’est plus nécessaire d’introduire des tubes de glissement de longueur variable. Il n’existe pas d’oscillations de phase, mais plutôt un mouvement asymptotique d’accélération.Les structures sont des guides d’ondes cylindriques dans lesquels on ralentit la vitesse de phase par des iris. Elles fonctionnent à 3 000 MHz (les sources hyperfréquences ont été développées pendant la Seconde Guerre mondiale) et permettent des champs accélérateurs moyens de 10 MV/m, donc environ dix fois plus élevés que dans une structure Alvarez. La machine se présente comme une suite de tanks accélérateurs entre lesquels sont insérés des quadrupôles magnétiques pour focaliser le faisceau.Ces linéaires accélèrent aussi des positrons. Le schéma est alors le suivant. Dans la première partie de la machine, on accélère un faisceau intense d’électrons. Ce faisceau est ensuite focalisé sur un convertisseur, derrière lequel on récupère les positrons produits. La conversion électron-positron se fait en deux temps. Tout d’abord, le ralentissement brutal de l’électron dans une cible se fait par émission d’un flux intense de rayonnement 塚. Ces 塚 interagissent à leur tour avec une cible de béryllium pour donner naissance à une paire électron-positron. Le rendement de conversion est faible (face=F0019 麗 1/100). Le convertisseur est suivi d’une optique grande acceptance qui permet de récupérer le maximum de positrons. Ceux-ci sont portés à l’énergie voulue dans la suite de la structure.Comme pour les linéaires à protons, le cycle utile est faible (face=F0019 麗 1/1 000). Cela rend délicates certaines expériences dites à coïncidences, c’est-à-dire où l’on veut discerner la simultanéité de certains événements au milieu d’autres sans corrélation.Le plus grand accélérateur linéaire à électrons est la machine du S.L.A.C. (Stanford Linear Accelerator), à Stanford. Cette machine a 3,05 km de longueur. Au départ, elle permettait d’atteindre 25 GeV. Récemment, le gradient accélérateur a été doublé et l’énergie finale est passée à 50 GeV.Les linéaires à inductionVia les équations de Maxwell, en régime pulsé, champ électrique et champ magnétique sont indissociables: Dans un linéaire à induction, par décharges successives de bancs de condensateurs, on crée séquentiellement des champs magnétiques pulsés à l’intérieur d’une série de tores de ferrite enfilés le long de l’axe du faisceau (fig. 16). Si la succession des décharges est correctement programmée, les particules cumulent les champs électriques accélérateurs d’induction. De tels dispositifs permettent d’accélérer des ensembles courts mais très intenses. Il n’y a eu que quelques exemplaires d’accélérateurs de ce type. Le linéaire à induction présente la particularité d’avoir un très bon rendement (rapport de l’énergie contenue dans le faisceau à l’énergie fournie par l’accélération). C’est pourquoi son utilisation est recommandée dans tous les projets futuristes de production d’énergie à partir de particules chargées, comme la fusion inertielle par ions lourds.5. Les accélérateurs circulaires de particulesGénéralitésPour monter en énergie, on pourrait concevoir des accélérateurs linéaires de plus en plus longs. Toutefois, avec des taux d’accélération de 1 MeV/m en protons, 1 GeV correspond à 1 km, 1 TeV correspondrait à 1 000 km. Pour limiter les dimensions de la machine, la nécessité de faire recirculer le faisceau à travers les mêmes cavités accélératrices s’impose. Le synchrotron est le plus classique des accélérateurs circulaires.Dans un synchrotron, les particules vont rester au voisinage du cercle déformé que constitue l’axe de la machine le long duquel on installe le tube à vide. Elles vont effectuer des millions, voire des milliards, de révolutions en passant périodiquement à travers les cavités accélératrices (fig. 17).Pour situer l’ordre de grandeur du gain apporté par une machine circulaire, considérons une machine conventionnelle comme le synchrotron Saturne à Saclay. On y atteint une énergie de 3 GeV en protons sur un périmètre de 100 m, c’est-à-dire qu’on réalise l’équivalent de 30 MeV/m. Si le seul critère est l’énergie crête atteinte, une machine circulaire est beaucoup plus compacte qu’un linéaire.Dans leur fonctionnement standard, les synchrotrons sont des machines pulsées avec trois phases essentielles dans leur cycle (fig. 18):– injection à basse énergie des particules issues de l’injecteur;– accélération jusqu’à l’énergie désirée;– extraction du faisceau.La fréquence de répétition du cycle varie entre 0,05 Hz et 50 Hz.Puisque le faisceau passe périodiquement à travers les cavités, il est donc courbé de 2 神 sur la périphérie de la machine. La fonction courbure est assurée par des dipôles magnétiques. L’intégrale de champ dipolaire à réaliser est proportionnelle à la quantité de mouvement p du faisceau:

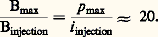

Dans un linéaire à induction, par décharges successives de bancs de condensateurs, on crée séquentiellement des champs magnétiques pulsés à l’intérieur d’une série de tores de ferrite enfilés le long de l’axe du faisceau (fig. 16). Si la succession des décharges est correctement programmée, les particules cumulent les champs électriques accélérateurs d’induction. De tels dispositifs permettent d’accélérer des ensembles courts mais très intenses. Il n’y a eu que quelques exemplaires d’accélérateurs de ce type. Le linéaire à induction présente la particularité d’avoir un très bon rendement (rapport de l’énergie contenue dans le faisceau à l’énergie fournie par l’accélération). C’est pourquoi son utilisation est recommandée dans tous les projets futuristes de production d’énergie à partir de particules chargées, comme la fusion inertielle par ions lourds.5. Les accélérateurs circulaires de particulesGénéralitésPour monter en énergie, on pourrait concevoir des accélérateurs linéaires de plus en plus longs. Toutefois, avec des taux d’accélération de 1 MeV/m en protons, 1 GeV correspond à 1 km, 1 TeV correspondrait à 1 000 km. Pour limiter les dimensions de la machine, la nécessité de faire recirculer le faisceau à travers les mêmes cavités accélératrices s’impose. Le synchrotron est le plus classique des accélérateurs circulaires.Dans un synchrotron, les particules vont rester au voisinage du cercle déformé que constitue l’axe de la machine le long duquel on installe le tube à vide. Elles vont effectuer des millions, voire des milliards, de révolutions en passant périodiquement à travers les cavités accélératrices (fig. 17).Pour situer l’ordre de grandeur du gain apporté par une machine circulaire, considérons une machine conventionnelle comme le synchrotron Saturne à Saclay. On y atteint une énergie de 3 GeV en protons sur un périmètre de 100 m, c’est-à-dire qu’on réalise l’équivalent de 30 MeV/m. Si le seul critère est l’énergie crête atteinte, une machine circulaire est beaucoup plus compacte qu’un linéaire.Dans leur fonctionnement standard, les synchrotrons sont des machines pulsées avec trois phases essentielles dans leur cycle (fig. 18):– injection à basse énergie des particules issues de l’injecteur;– accélération jusqu’à l’énergie désirée;– extraction du faisceau.La fréquence de répétition du cycle varie entre 0,05 Hz et 50 Hz.Puisque le faisceau passe périodiquement à travers les cavités, il est donc courbé de 2 神 sur la périphérie de la machine. La fonction courbure est assurée par des dipôles magnétiques. L’intégrale de champ dipolaire à réaliser est proportionnelle à la quantité de mouvement p du faisceau: Au cours du cycle d’accélération, l’impulsion p = m v des particules passe de p injection à p max, correspondant à l’énergie maximale; parallèlement, le champ croît de Binjection à Bmax. Afin d’éviter les défauts de champs liés aux courants de Foucault (laminations), au champ rémanent, et à la saturation, on se limite en général à un rapport:

Au cours du cycle d’accélération, l’impulsion p = m v des particules passe de p injection à p max, correspondant à l’énergie maximale; parallèlement, le champ croît de Binjection à Bmax. Afin d’éviter les défauts de champs liés aux courants de Foucault (laminations), au champ rémanent, et à la saturation, on se limite en général à un rapport: Au cours du cycle, la vitesse des particules augmente. De ce fait, la période de révolution (intervalle entre deux passages par la cavité accélératrice) diminue. Pour maintenir l’effet accélérateur, on réalise la condition de synchronisme (origine du mot synchrotron) entre la fréquence f RF des cavités et la fréquence de révolution fr des particules. Comme dans le cas des cyclotrons, on peut choisir f RF = hfr , c’est-à-dire de travailler sur un harmonique h de la fréquence de révolution. Pour des raisons pratiques évidentes, on choisit h pour que f RF tombe dans la gamme radiofréquence. Pendant une moitié de la période RF, la tension a le signe correspondant à une accélération. C’est pour cet intervalle que vont se grouper les particules stables. Il y a donc h paquets de particules sur la périphérie de la machine.Il est bien évident que le faisceau ne peut faire des millions de tours sans être focalisé. Le principe de focalisation dans les machines circulaires a suivi trois étapes.La focalisation faibleAu tout début, avec l’objectif d’obtenir des machines compactes, on a imaginé d’introduire une focalisation répartie à l’intérieur des dipôles de courbure. Ce fut l’époque de la focalisation faible.Comme dans le cas du cyclotron, un secteur à champ magnétique homogène ne focalise pas dans le plan vertical. Si l’on incline les pôles nord et sud symétriquement par rapport au plan médian, alors les lignes de champs s’incurvent et, pourvu que l’angle ouvre l’aimant vers l’extérieur (côté opposé au centre de courbure), la force magnétique rabat les particules vers le plan médian (fig. 19).Néanmoins, il est difficile d’ouvrir trop largement les pôles car, ce faisant, on diminue (ou on augmente) le champ sur la trajectoire externe (ou interne) et, de ce fait, on défocalise trop le mouvement horizontal. Soit n l’indice de champ défini par: